Разрешение. Мифы и реальность. MTF и её измерение.Рассмотрев в общих чертах объективы и матрицы, пора коснуться одной

довольно популярной величины, на которую они напрямую влияют — разрешения.

Ни один сравнительный обзор не обходится без её обсуждения, в форумах

ломаются копья — у чьей камеры оно больше? Попытаемся разобраться, что

это такое - разрешение, и заслуживает ли оно таких "почестей". Наши

разборки будут напоминать матрёшку — вот, кажется, дошли до сути, а она

вновь раскрывает внутри себя другую, и так много раз... Внешняя матрёшка. Вновь мегапиксели.Как и в случае с размером матриц, большинство простой публики (на

этот раз конечно не 90, а 60-70% примерно) свято верят, что разрешение

измеряется в Мегапикселах. Т.е. 5-мпиксельная камера заведомо детальнее

4-мегапиксельной и так далее. Для многих конкретных камер и конкретных

условий это даже верно. Но далеко не для всех. Вспомним определение

разрешения (для начала грубое) — это количество мелких деталей которое

способен передать снимок. Таким образом, если объектив, скажем,

8-мегапиксельной камеры намазать вазелином, то количество мелких

деталей на снимке явно будет меньше чем даже у 3-мегапиксельной камеры.

В реальной жизни роль вазелина играют уже упоминавшиеся аберрации, а

также переотражения внутри объектива. Как же учесть это всё "одним

числом"?. Чтобы не спорить о том какие объекты снимать и какие детали

считать, договорились снимать чёрно-белые полоски. Сколько полосок без

"смазывания" влезет в кадр (обычно по короткой стороне) — таково и

разрешение (обычно в цифровой фотографии, в отличие от старых ГОСТов,

одну чёрную линию считают за две — типа "чёрная+белая", типичные

значения получаются от 1000 до 1600 линий на высоту кадра). Казалось

бы, всё строго — делаем миру (образец с разной частотой полосок),

снимаем, считаем полоски и всё. Даже в журналах часто эти цифры

публикуют в сравнительных тестах... но, оказывается, что не всё так

просто. Но прежде чем раскрыть вторую матрёшку, оглянемся на первую.

Всё-таки - важны мегапиксели или нет? Или дело только в объективе?

Ответ прост - мегапиксели всего лишь необходимое, но не достаточное

условие. Чтобы разрешить 1000 линий, кадр должен иметь примерно 1500

пикселей в высоту. Этот коэффициент около 1,5 связан с тем, что

вероятность "точного попадания" линии миры на линию пикселей близка к

нулю. Линии всегда попадают "между", в большей или меньшей степени. Вот

из статистического усреднения и берётся этот факт, что для отображения

каждых двух линий нужно три ряда пикселей. Таким образом, зная размер

кадра можно прикинуть максимально возможное разрешение, которое

достигалось бы при идеальном объективе: | Мегапиксели | Размер кадра при 4:3, пикселей, грубо | 2450*3250 | 1650 |

|---|

Во избежание недоразумений, отмечу, что вышеприведённые цифры

относятся к статистически правильной методике измерений любого

параметра - когда эксперимент повторяют несколько раз и усредняют

результаты. Разумеется, можно в пропагандистских целях "подогнать"

расположение миры и получить (и даже опубликовать!) кадр с разрешением

до полутора раз большим (или просто выбрать из всех экспериментов

лучший). Но к реальной жизни и реальным снимкам эти нечистоплотные

методы не имеют отношения. Вторая матрёшка. Линии на высоту.На пути подсчёта линий нас подстерегают две опасности. Первая — формальная. Почему-то общепринято считать вертикальное и

горизонтальное разрешения. Однако из-за структуры матрицы (расположения

пикселей) оказывается, что диагональное примерно в 1,4 раза больше.

Этим поспешила воспользоваться одна известная фирма, которая просто

повернула матрицу на 45 градусов и назвала модным словом "Супер ЦЦД". С

3 миллионов сенсоров электроника камеры интерполировала 6-мпиксельную

картинку. Скептики тут же принялись мерить разрешение своими мирами и с

удивлением обнаруживали что таки-да, "дед Мороз существует" - матрица

на уровне 5-6мегапиксельных "обычных". Но никто не догадался повернуть

миру под 45 градусов - тогда всё станет на свои места - разрешение

"обычных" увеличится, а "супер" — снизится, и хвалёные 6 мегапикселей

будут на уровне полутора "обычных". А поскольку в реальной жизни редко

встречаются ровные параллельные линии, то в среднем разрешение как было

на уровне 3-амегапиксельных, так и осталось, что блестяще

подтверждается тем фактом, что многие владельцы "волшебных" камер,

поиграв с интерполированным разрешением, вернулись на стандартное 3Мп

для экономии места на флеш-карте, т.к. не заметили явных улучшений. Вторая опасность — принципиальная и связана с размытостью понятия

"линии различимы". На словах всё выглядит достаточно гладко и понятно.

В реальности выясняется, что - "различимость" линий не дискретна (различимы -

неразличимы), а непрерывна — (различимы хорошо, не очень, плохо, очень

плохо и т.п.). На самом деле просто плавно падает контраст с единицы до

нуля. Поэтому разные наблюдатели видят переход от "плохо различимы" к

"практически не различимы" в РАЗНЫХ местах. Этот эффект не зависит от

фотосистемы и наблюдается и в плёночной фотографии.

- в

цифровой фотографии кроме этого из-за структуры матрицы добавляются

цветные разводы, муар и даже "греческий орнамент", что ещё более

усложняет процесс визуального тестирования.

На иллюстрации приведён типичный (не самый сложный) пример. В

зависимости от "строгости" наблюдателя колебания разрешения легко

достигают 20-40%. В результате ценность цифр, приводимых в обзорах,

становится сомнительной. Как мы видели из предыдущей таблицы,

максимальные цифры для 3Мп и 5Мп отличаются всего лишь на 30%, поэтому

20-40% - это катастрофически много. Лирическое отступление.

Похожая ситуация складывается с другими "паспортными" параметрами

бытовой техники — например мощностью и частотным диапазоном недорогих

аудиосистем. Мощность можно измерять при разных значениях искажений, а

нижнюю границу частотного диапазона - при разном падении АЧХ, чем

изготовители активно пользуются. В результате мы часто видим

пластиковые компьютерные колонки за 50уе с диапазоном от 40Гц и

качественные HiFi колонки за 600 уе с диапазоном от 45Гц. Угадайте, у

кого из них басы глубже на самом деле? Аналогия с акустикой не случайна. Действительно, если принять

звуковое давление на средних частотах за единицу ("нормировка АЧХ"), то

с понижением частоты оно будет плавно падать до нуля и обычно нижней

границей называют ту частоту, при которой давление равно либо 0,5, либо

0,25, либо 0,1 (в зависимости от методики, соответственно и результаты

— разные). При этом сама АЧХ(Амплитудно-Частотная Характеристика)

достаточно объективна и даёт гораздо бОльшее представление чем сухая

цифра "границы". Нельзя ли и в оптике вместо "границы" разрешения снять

плавную кривую падения контраста при росте частоты штрихов? Именно эта

кривая и получила название Modular Transfer Function (MTF) - функция

передачи модуляции. Более подробно (на английском) можно почитать здесь, а кратко я изложу ниже. Итак, если вместо "классических" штрихов с прямоугольным графиком

яркости использовать "синусоидальные", а функцию "контраста" от частоты

определить как (Iw-Ib)/(Iw+Ib), где Iw и Ib —- яркости изображений "самой белой" и "самой тёмной" точки на данной частоте линий, то MTF(частоты)=КОНТРАСТ(частоты)/КОНТРАСТ(низкой частоты). Таким образом, на низкой частоте MTF равна единице, а с ростом

плавно падает до нуля (когда изображения линий сливаются, контраст

становится нулевым). Классически определяемое "разрешение"

соответствует частоте, при которой MTF становится равной примерно 0,1. Как и АЧХ в акустике, MTF способна дать гораздо больше информации.

Так, два объектива, имеющие одинаковое разрешение (скажем, 1600lph)

могут иметь разные графики MTF — у одного график опускается сразу от

50lph вниз, плавно достигая 0,1 при 1600 lph, а у другого держится

возле 0,95 "до последнего", и лишь начиная с 1200lph круто падает вниз.

При частоте 800-1000lph у первого будет MTF 0,25, а у второго — 0,95. В

результате снимки первого будут заметно более вялыми ("мыльными"). Тем

не менее формальное разрешение у них действительно одинаково. Ну уж теперь-то, кажется, всё строго. Измеряем MTF, публикуем

сравнение графиков и строим аппараты по ранжиру... Но не будем

торопиться. Всё опять не так просто. Третья матрёшка. MTF.

Измерения и влияние шарпенинга.Измерить MTF можно даже в домашних условиях.Для этого потребуется

всего лишь струйный принтер (720dpi и выше), несколько листов фирменной

"струйной" бумаги, а также несколько небольших бесплатных программ,

скачанных из Сети. Как это всё сделать, подробно описано у меня в

статье Измеряем MTF самостоятельно .

В частности, я снимал графики для нескольких объективов к Canon D60.

Результаты для угла кадра представлены ниже (линии на высоту кадра

можно получить умножением цифр на оси Х примерно на 30, график просто в

привычных "плёночных" координатах):  Подробное обсуждение этих графиков есть по упомянутой ссылке, нас же

здесь интересует сравнение красных и зелёных линий. Красные принадлежат

профессиональному объективу 16-35mm/2.8L стоимостью под полторы тысячи

долларов. Зелёные - наидешевейшему, наибюджетнейшему пластмассовому

28-80mm/3,5-5,6 за 100 долларов. Если сравнивать тонкие линии — всё

логично и "L-ка" оставляет бюджетник далеко позади. Но взгляните на

толстый зелёный пунктир! Он отличается от остальных "всего лишь"

другими (+1деление) установками шарпенинга на камере (на самом деле - в

RAW-конверторе, но это одно и то же) и очень умеренным шарпенингом в

Фотошопе (ещё грубо говоря "1 деление"). Но в результате он полностью

догнал L-ку! (Понятно, что если применить шарп к L-ке она вновь всех

"сделает", но речь сейчас о другом!) Мы подошли к ключевому моменту. Поставьте себя на место

производителя фотокамеры. У Вас есть два пути увеличения разрешения -

сделать замечательный резкий объектив уровня L-оптики

(+500-1000долларов к цене камеры в зависимости от размера матрицы) или

просто "перешить" в её процессоре уровень шарпенинга на одно-два

"деления" в большую сторону (бесплатно!!!). Как Вы думаете, что

выбирают реальные производители? Разумеется шарпенинг! В результате

увеличиваются шумы и понижается реальная чувствительность (если её

определять как значение при фиксированном уровне шума). Но это никого

не волнует, потому что уровень шума измерять толком не научились, в

обзорах он фигурирует редко, а вот высокое разрешение (вместе с

мегапикселями и зумом) — сильный маркетинговый козырь. Косвенное

подтверждение тому - наличие ISO400 и даже иногда ISO800(!) в камерах с

матрицами 1/2,5"! Что мы имеем ещё плохого от "встроенного" шарпенинга, кроме

увеличения шумов? Мы имеем, образно говоря, "потолок" детализации. Т.е.

дальнейший шарпенинг в Фотошопе больше не приводит к её увеличению без

сопутствующих артефактов и искажений, "несовместимых с жизнью", в

отличие от камер без встроенного шарпа. Там с помощью Фотошопа иногда

можно вполне "догнать" разрешение до "накачанных" лидеров (разумеется

ценой того же шума, но у нас по крайней мере есть выбор!). Последняя матрёшка. Крах разрешения.Итак, мы пришли к интересному выводу. Измерять MTF (и, как частный

случай, — разрешение) можно, но не имеет смысла до тех пор, пока мы не

сможем нормировать встроенный шарпенинг. В случае если камеры имеют

формат RAW и построены на одинаковых матрицах это сделать просто —

выставлением одинаковых параметров конвертора. Но таких случаев очень

немного. Во всех же остальных случаях нормирование НЕВОЗМОЖНО. У большинства камер имеется три градации (низкий-норма-высокий), но

"низкий" одной может соответствовать "высокому" другой, поэтому

установка всех испытуемых в "норму" проблему не решает. Если матрицы

одного размера и производителя, можно косвенно судить о шарпе по уровню

шумов. Но и тут разная "начинка" камер и разные "фирменные"

шумоподавители иногда могут портить картину. Если же шарпинг не

нормировать, то всегда даже объективно слабая, но "пошарпленная" камера

будет выигрывать в тестах у объективно сильной, но не шарпленной (как в

приведённом графике заведомо слабый 28-80 практически выиграл у

ВДЕСЯТЕРО более дорогого 16-35L). Совершенно ясно, что с заменой строгой решётки MTF на реальные кадры

проблема разного шарпа никуда не уйдёт и скачивания различных тестовых

снимков не помогут, особенно учитывая лёгкость их подделки. Легко можно

экспортировать "штамп фотоаппарата"(EXIF) из оригинала в обработанный в

фотошопе снимок и выдать его за оригинал. Кроме того, вне обсуждения осталось то, что на разных положениях

зума и в разных частях кадра разрешение даже одного и того же объектива

существенно разное, и как (и с какими весовыми коэффициентами) его

усреднять - тоже вопрос открытый. Так что же делать? Как сравнивать разрешения?

А плюньте! Не надо их сравнивать! Не в них счастье!

Как уже было сказано при обсуждении ГРИП, средний глаз на фото 13*18

различает лишь 1/1500 диагонали, что для фото 15*20 даёт примерно

1000lph(линий на высоту). Таким образом разница между 1200 и 1400 lph в

95% любительских случаев абсолютно несущественна. Гораздо более важны,

например, хроматические аберрации, которые на "гиперзумах" просто

глазом видно... ЗАМЕЧАНИЕ1: разумеется вышеприведённый совет относится лишь к

изделиям известных оптических фирм нормальной и высокой ценовой

категории (от 3 мегапикселей), если же Вы нацелились на некую

супердешёвую веб-камеру или мыльницу никому не известной марки

"хрен-тек" за десять-двадцать долларов, разрешение проверить абсолютно

необходимо. Пластмассовый дверной глазок может давать что угодно :-)

ЗАМЕЧАНИЕ2: понятно что высокое разрешение при прочих равных всегда

лучше низкого ("заблюрить" в Фотошопе никогда не поздно), и я не хочу

сказать, что оно ВООБЩЕ неважно. Просто на данном историческом этапе и

у большинства конкретных доступных на рынке камер оно стоит далеко не

на первом месте в качестве критерия выбора. О триединстве шума, чувствительности и разрешенияКак мы уже видели выше, от алгоритмов шарпенинга и шумоподавления,

встроенных в камеру, зависит "пропорция" между шумом, чувствительностью

и разрешением. Т.е. "улучшая" одно, мы "ухудшаем" другое. Как и в

большинстве других случаев, нельзя однозначно сказать — что суммарно

"лучше" и что "хуже" — это зависит от задач и вкусов (кто-то не выносит

"мыла", а кто-то шума). Важно просто понимать это единство и

взаимообусловленность. Иногда при сравнении близких по классу камер

можно слышать заявления типа "камера А больше мылит, зато меньше шумит,

чем камера Б". В таких случаях всегда хочется предложить вместо

настроек "по умолчанию" снизить уровень шарпа у камеры Б и повысить — у

камеры А. Не исключено что результаты либо сравняются, либо даже

"поменяются местами".

Вообще я, к большому сожалению, не видел ещё НИ ОДНОГО грамотного

обзора, где всерьёз изучались встроенные установки и предпринималась

хоть какая-то попытка выставить их "сопоставимо". Обычно отдельно

снимают шум от чувствительности, затем отдельно - сравнивают разрешение

при одном и том же ISO и диафрагме. И всё это при настройках "по

умолчанию"! RAW, TIFF и JPG - в чём разница?Даже если Вы не в ладах с математикой, не пропускайте нижеследующее

"математическое отступление" — постарайтесь его понять, т.к. всё

дальнейшее изложение будет неоднократно обращаться к полученным там

выводам. Профессиональных же математиков я попрошу не судить меня за

нестрогость изложения и многократное повторение очевидных вещей. Опыт

показывает, что для большинства читателей они не очевидны. Математическое отступление.Поговорим о преобразовании функций. Для простоты возьмём функцию

F(X)=X на отрезке [0,1]. Легко себе представить её график - это прямая

линия под 45 градусов. Теперь применим к ней последовательно пару

функций — G1(X)=100*X и G2(X)=0.01*X. Финальная функция

G2(G1(F(X)))=0.01*100*X=X очевидно никак не изменилась — всё тот же

отрезок под 45 градусов. Таким образом, преобразование G1 было обратимым — оно имеет т.н. обратное

преобразование G2. Нетрудно видеть, что и преобразование H1(X)=0.1*X

также обратимо и имеет обратное - Н2(Х)=10*X. Кроме этого, и порядок

применения обратимых преобразований не важен:

G2(G1(F(X)))=G1(G2(F(X))). Всё так хорошо лишь пока мы находимся на

"территории математики" - все числа у нас действительные, т.е. могут

принимать любые значения и быть измерены с любой точностью. Но как только от "математических" чисел мы переходим к

"компьютерным"(или "цифровым"), т.е. к ячейкам памяти, появляются два

фундаментальных ограничения: - диапазон ограничен максимальным числом М (т.е. Y

- точность ограничена числом m (т.е. cуществуют только Y=k*m, где k-натуральное число, а все остальные "округляются" до этих)

Представим что на рассмотренных выше примерах M=1 и m=0.01., кроме этого считаем значения ограниченными снизу нулём.

- Исходная функция F изменится мало - появятся маленькие "ступеньки" по 0.01 (см График, красные точки)

- Применим

функцию G1. На всех точках при X>0.01 она "обрежется" до единицы и

после применения G2 на всём отрезке кроме нуля результат будет 0.01

(см. График, красная линия)

- Применим функцию H1. Вместо

ста разных значений Y теперь принимает всего десять, т.к. от 0 до 0.1

можно разместить всего десять отсчётов с точностью m. Применение обратной функции H2 не меняет картину, а лишь увеличивает шаг в десять раз (см. График, красный пунктир)

- Применение

функций в обратном порядке ("G2 затем G1" и "H2 затем H1") разберите

самостоятельно, ответ - на графике синим цветом. Видно, что результат

не совпадает ни с чем: ни с функцией F, ни с результатом "прямого"

применения пары G1G2 и H1H2.

- Легко даже в уме прикинуть

результат не только для умножения, но и для сложения, например для

последовательного применения J1(X)=X+0.5 и J2(X)=X-0.5.

Обобщим полученные на этом простом примере результаты. Итак, при

ограниченном диапазоне значений и ограниченной точности (разрядности)

данных, строго говоря, ЛЮБОЕ преобразование МОЖЕТ перестать быть

обратимым, и, более того, МОЖЕТ приводить к потере информации.

Потеря информации получается ДВУХ сортов: "ограничение" и "потеря

разрядности". В приведённом выше примере умножение на 10 (и тем более

на 100), а также сложение (и вычитание) 0.5 приводило к "ограничению".

А в случае, когда мы сначала делили на 10 (и тем более на 100) - мы

видели потерю разрядности. Поясню выделенное слово "МОЖЕТ". На приведённой в примере функции

F(X)=X легко доказать что не только МОЖЕТ, но ВСЕГДА необратимо. Но для

некоторых других функций это не так. Например функцию F2(X)=0.1*X можно

смело "подвергать" воздействию умножения на 10 - ограничения не

произойдёт. Причина - диапазон значений не подходит "достаточно близко

к границе". Впрочем, от умножения на 100 это "не спасёт". Другой

пример: функцию F3(X)=0.5*X можно безболезненно умножать на два (или

прибавлять 0.5), а вот на 10 умножать (или прибавлять 0.8) без

ограничения уже не выйдет. Обобщим вновь: чем ближе значения

исходной функции к границам диапазона, тем более "мягкими" должны быть

преобразования для того, чтобы оставаться обратимыми. И, наконец, последнее. Выше я показал, что последовательное

применение двух преобразований (прямого и обратного) не совпадает в

"цифровом" случае с исходным результатом, т.е. с тождественным

преобразованием, которому в математике равно последовательное

применение прямой и обратной функции. Но если это справедливо даже для

тождественного преобразования(частный случай), то совершенно очевиден и

более общий случай ЛЮБОГО преобразования, являющегося математической

комбинацией двух других: если "в математике" А(В(...))=С(...), то в

общем случае "в цифре" A(B(...)) НЕ РАВНО С(...). Иными словами, если к

одной и той же цели "математически" можно придти разными путями, то эти

же пути "в цифре" дадут строго говоря РАЗНЫЙ результат. RAW, JPEG, TIFF и потеря данных. Мифы и реальность.Часто можно слышать и читать в популярных изданиях утверждение, что

"JPEG — формат с потерей данных, а вот TIFF и RAW — нет". Этим же

утверждением часто "оправдывают" отсутствие сохранения в RAW у

некоторых камер ("RAW нет, зато есть TIFF!"). Некоторые авторы идут ещё

дальше и даже при наличии обоих форматов в камере (RAW и TIFF) советуют

сохранять в TIFF, "как более совместимом и не требующем конвертации".

Все эти утверждения и советы в корне неверны. А что же на самом деле? А на самом деле единственным форматом без потери данных является

RAW. Степень потери данных при сохранении в TIFF и JPEG (максимального

качества) примерно одинакова на 99% любительских сюжетов. А поскольку время сохранения файла TIFF в камере на порядок больше, чем JPEG, применение формата TIFF в цифровых камерах вообще нецелесообразно. Утверждение категоричное и "еретическое", но лишь на первый взгляд.

Защитники формата tiff наверняка начнут иллюстрировать его преимущества

съёмками мелких контрастных чёрно-белых мир. И действительно получат

более высокое разрешение и некоторые артефакты у формата JPEG. Но это

как раз тот 1%, про который я упоминал. Большинство (99%) РЕАЛЬНЫХ

любительских сюжетов не содержат столько мелких контрастных деталей в

таких количествах. На РЕАЛЬНЫХ сюжетах потери от JPEG-сжатия по

сравнению с TIFF настолько ничтожны, что даже на мониторе ПРИ СЛЕПОМ

ТЕСТИРОВАНИИ (когда не знаешь что где) практически невозможно увидеть

разницы. После распечатки - тем более. Гораздо заметнее другие потери данных, которые происходят при сохранении в камере, неважно - в TIFF ли или в JPEG. Про них практически никто не вспоминает, а знать о них необходимо. Итак, на самом деле все цифровые камеры снимают в RAW, просто не все его отдают наружу.

RAW - это просто оцифрованный сигнал яркости с каждого сенсора,

прошедший лишь предварительную (калибровочную) обработку firmware

камеры (исправление отклонений ДАННОЙ матрицы от среднестатистической,

иногда - "софтовый ремонт"(ремаппинг) битых пикселей). Это чёрно-белый

массив данных, не всегда даже совпадающий по координатам с конечной

картинкой (особенно в случае SuperCCD и им подобных). Но это уже

"цифровые" данные, они имеют свою разрядность (8, 10, 12, 16бит) и

ограничения (соответственно 255, 1023, и т.д.). Дальше у этой

информации два принципиально разных пути. Она либо записывается на

флеш-память в файл *.CRW (иногда с внутренним сжатием на манер ZIP-а,

без потерь), либо (в большинстве случаев) поступает в процессор

фотоаппарата на обработку. Процессор делает следующие вещи: - интерполирует RGB цвета конечных точек изображения из сигналов окружающих сенсоров всех цветов;

- применяет цветокорректировку в соответствии с настройками Баланса Белого;

- применяет цветокорректировку в соответствии с настройками контраста и насыщенности;

- применяет шарпинг (или блюринг) в соответствии с установками шарпа.

- конвертирует результат в 8-битный цвет;

И лишь затем результат записывается в TIFF (или JPEG) формате на носитель. Вы видели, сколько преобразований делает процессор камеры? Поскольку

разрядность каждого цвета невелика (от 8 до 12 бит, как правило), то

ограничение диапазона составляет всего лишь сотни или тысячи, т.е.

несильно отличается от приведённого в математическом отступлении

примера. Таким образом, каждое преобразование в процессоре камеры необратимо и теряет данные.

Сама по себе потеря данных неизбежна - для конечного результата

(просмотра на мониторе, печати на бумаге или записи на компакт-диск)

нам, так или иначе, потребовалось бы проделать эти преобразования - не

в фотоаппарате, так в RAW-конвертере и Фотошопе. Вопрос лишь в СТЕПЕНИ

этих потерь. Если мы "угадали" с настройками и сразу получили "хорошую"

картинку - нам повезло. А вот если для данного сюжета какой-то из

параметров выбран неудачно (баланс белого, контраст, шарп), то нам

приходится в Фотошопе делать его корректировку. Т.е. вместо "прямого"

пути C() выбирать "окольный" - А(B()). В математическом отступлении

наглядно показано, что это ни к чему хорошему не приводит (учитывая

8-битность JPEG). Т.е., совсем "на пальцах": если, скажем, неудачно

сработавший автомат баланса белого вместо того чтобы записать в файл

градиент от 0 до 255 по одному из каналов (аналог нашего отрезка от 0

до 1) предварительно "умножит его на два", то в Фотошопе мы конечно

"поделим обратно на два", но на половине данных произойдёт ограничение

- мы никогда не узнаем что там раньше было - градиент ли, рисунок ли... Вся неприятность ситуации состоит в том, что понять насколько удачны

выставленные при съёмке параметры можно только ПОСЛЕ съёмки - посмотрев

результат, желательно на большом мониторе. Т.е. когда исправить уже

поздно. А формат RAW (в случае если его камера "отдаёт") позволяет

вообще не выставлять никаких параметров цвета-контраста-шарпа при

съёмке (всё в авто)! На компьютер ставится точный программный аналог

камерного процессора (RAW-конвертер) и можно получить на выходе

варианты при ЛЮБЫХ параметрах и сравнить их между собой в спокойной

обстановке. При недостатке же времени можно запустить пакетное

конвертирование с параметрами "AS SHOT" и получить ровно те же JPEG-и,

которые камера выдала бы на полном автомате. Счастливым обладателям 12-битного RAW(в отличие от 8-битного) "в

нагрузку" даётся возможность экспокоррекции плюс-минус 2EV (2 "стопа") почти

без потери качества(относительно соответствующего повышенного ISO в

случае положительной коррекции) ЗАДНИМ ЧИСЛОМ, при конвертации. Т.е.

кадры, снятые на ISO400 нормально, и кадры, снятые на ISO100 с

недодержкой и "вытянутые" в конверторе, отличаются мало. Это позволяет

не слишком заботиться о точности экспозамера и не тратить время на

точечные замеры - пусть ценой некоторого шума, но детали в тенях не

пропадают в большинстве случаев. Насколько существенны те "ужасы потерь данных", описанные выше?

Почему владельцы многочисленных цифромыльниц без RAW не стонут от

несправедливости? Может всё это вообще на глаз не видно? Для тех, кто

внимательно читал "математическое отступление", ответ уже должен быть

очевиден: чем цветастее и контрастнее снимаемый сюжет, чем выше

диапазон его яркостей, тем меньшие ошибки он простит. Кроме самого

сюжета, сдвигают значения к границам и ошибки экспозиции (недодержка,

передержка). Если автомат поставил "среднюю" экспозицию, то сюжетно

важный объект может оказаться недо/пере-свеченным, т.е. наиболее

чувствительным к дальнейшим ошибкам обработки (близок к границам). Или,

резюмируя: разница между технологиями "JPEG-Фотошоп" и

"RAW-конвертер-Фотошоп" малозаметна на правильноэкспонированных

низкоконтрастных сюжетах, но начинает становиться тем заметнее, чем: - контрастнее сюжет

- больше недодержка/передержка(или объект в тени или блике)

- больше ошибка в съёмочных параметрах (например забыли снять режим ББ "ламп накаливания" при выходе на улицу)

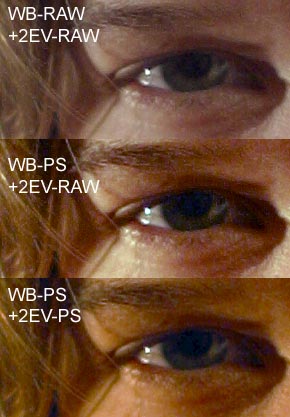

Вот типичная иллюстрация вышесказанному (см. фото): объект был

недодержан на две ступени, да и автомат ББ сработал не блестяще. В

результате пришлось корректировать и ББ, и экспозицию. Худший результат

- коррекция "готового" 8-битного файла в Фотошопе (PS=фотошоп). Средний

- коррекция экспозиции в RAW, а цвета - в шопе. И, наконец, лучший -

коррекция всего в RAW-конверторе. При этом был применён метод "РББ

задним числом", о котором речь пойдёт чуть ниже.  |  |  | | Оригинал (общий вид кадра, сильно уменьшено) | Примерная цель (общий вид кадра, сильно уменьшено) | И

сравнение разных способов её достижения (небольшой фрагмент, 100%).

Артефактов JPEG от выкладывания в Сеть здесь нет, все что видно -

артефакты цветокоррекции и "вытягивания". Обратите внимание на синюю

рваную пелену на глазу. Желтизну кожи на нижних вариантах без

избирательной обработки убрать невозможно - сильно гадятся другие цвета

(которых не видно на фрагменте). Единственный способ далее уточнять

цветопередачу - избирательное применение к разным участкам разных

фильтров - непозволительно трудоёмок для любителя. |

Казалось бы, если не ошибаться с балансом белого и экспозицией (как

намеренно сделано в приведённом примере чтобы различия были видны

НАГЛЯДНО), всё это не нужно... Но, - во-первых, не ошибаться очень трудно. Ручной баланс

белого, конечно, многое спасает, но катастрофически снижает

оперативность (вот Вы увидели, что на вечеринке завязалось нечто... или

что Ваш ребёнок заполз куда-то и вот сейчас... Если Вы начнёте

обкладывать место действия листами белой бумаги и лихорадочно

вспоминать на какие кнопки нажимать для выставления ББ, в 99% случаев

интересный момент будет упущен.) Единственный выход - снимать на

автомате, а он часто ошибается. Второй выход - РББ "задним числом" есть

ТОЛЬКО у снимающих в RAW (о нём - чуть ниже).

- во-вторых,

даже у "правильно" сделанного "в среднем" кадра могут оказаться

интересные (сюжетно-важные) детали в тенях/светах, особенно если они не

в центре кадра. Конечно, на "продвинутых" моделях кроме

"фокус-лока"(блокировки фокуса перед окончательным кадрированием) есть

ещё и "экспо-лок". Но по опыту им пользуются очень немногие, хорошо

если с "фокус-локом" освоятся... Да и неудобно это, неоперативно... Не

совсем для любителя.

Не удержусь и приведу ещё одну, возможно, даже более наглядную,

иллюстрацию различий RAW/TIFF/JPG форматов для съёмки (по совету

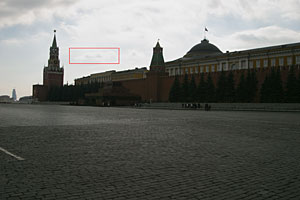

читателей). Это-снимок на стандартной экспозиции, сразу в JPG (Обратите внимание на выбеленное небо...):

Это - он же, с той же экспозицией, но "вытащенный" из RAW. Небо "проявилось.

А ниже - не белый прямоугольник, а тот самый кусочек неба, который

обведён в рамку, но из оригинального JPG (виден уменьшенный, по ссылке

откроется оригинальный, все сжатия из фотошопа на качестве 12, т.е.

максимальном)

Я специально размещаю его для тех, кто свято верит, что в Фотошопе

можно "вытянуть" что угодно без потерь - отличный шанс попробовать

вытащить облако... | А

это - мои результаты "вытаскивания" деталей облака. Я решил сузить и

упростить задачу - заняться ТОЛЬКО облаком. Почему? Дело в том, что

существует очень много способов затемнить небо, не трогая кремль, в том

числе довольно трудоёмкие (вырезание в другой слой, маскирование,

кривые, кисть истории и т.п.). Всегда найдутся фанатики перепробовать

все и обвинить меня в неквалифицированном владении фотошопом. Поэтому,

чтобы не тратить время, забудем про кремль и предположим что нам важно

максимально детализировать именно облака (показать "грозу над

Кремлём"). Совершенно ясно, что если детали в файле есть, то и более

общую задачу удастся решить, а если нет - то никакие маски и кисти не

помогут...

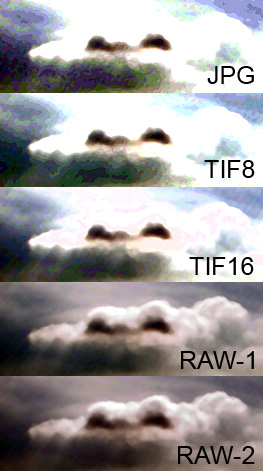

Пояснения: JPG - снято сразу в JPG, TIF8 - снято сразу в TIF, TIF16 - так было бы, если бы камера сохраняла 16-битный TIF, RAW-1 - коррекция из RAW на одну ступень, RAW-2 - на две ступени.

Наглядно видно, что самый резкий шаг проходит между TIF16 и RAW-1, т.е.

максимальное количество информации теряется в камере не от сжатия в JPG

и даже не от преобразования в 8-битный цвет, а на предыдущих этапах

(интерполяции и цветокоррекции). В RAW она сохраняется и "извлекается"

конвертером, а даже в 16-битном TIF-е оказывается потерянной. |

|